{$te}

Мы часто слышим о том, что проект для гранта должен быть в определенном степени «новым», а еще лучше – «инновационным» решением. Почти в каждом конкурсе есть отдельный критерий, который это оценивает. Об этом рассказывают на тренингах и марафонах. И вот, соискатели занимаются поиском каких-то супер-новых моделей и подходов, украшают свои описания модными или редкими терминами, рисуют фантастические графики и … получают «штраф за новизну».

Идея наличия такого штрафа приходила ко мне и раньше. Я встречал его признаки анализируя итоги аудита заявок своих клиентов и последующие результаты на конкурсе (или наоборот, когда ко мне уже приходили с проигравшей хорошей заявкой). Но теперь я нашел научное исследование по данному поводу, которое не только подтвердило гипотезу, но и углубило мое понимание причин ее существования. Веселее не стало.

Итак.

Наличие такого систематического штрафа была исследована и доказана профессором Кевином Дж. Будро с коллегами еще в 2012 году. Результаты были опубликованы Гарвардской Школой Бизнеса.

Итак.

Наличие такого систематического штрафа была исследована и доказана профессором Кевином Дж. Будро с коллегами еще в 2012 году. Результаты были опубликованы Гарвардской Школой Бизнеса.

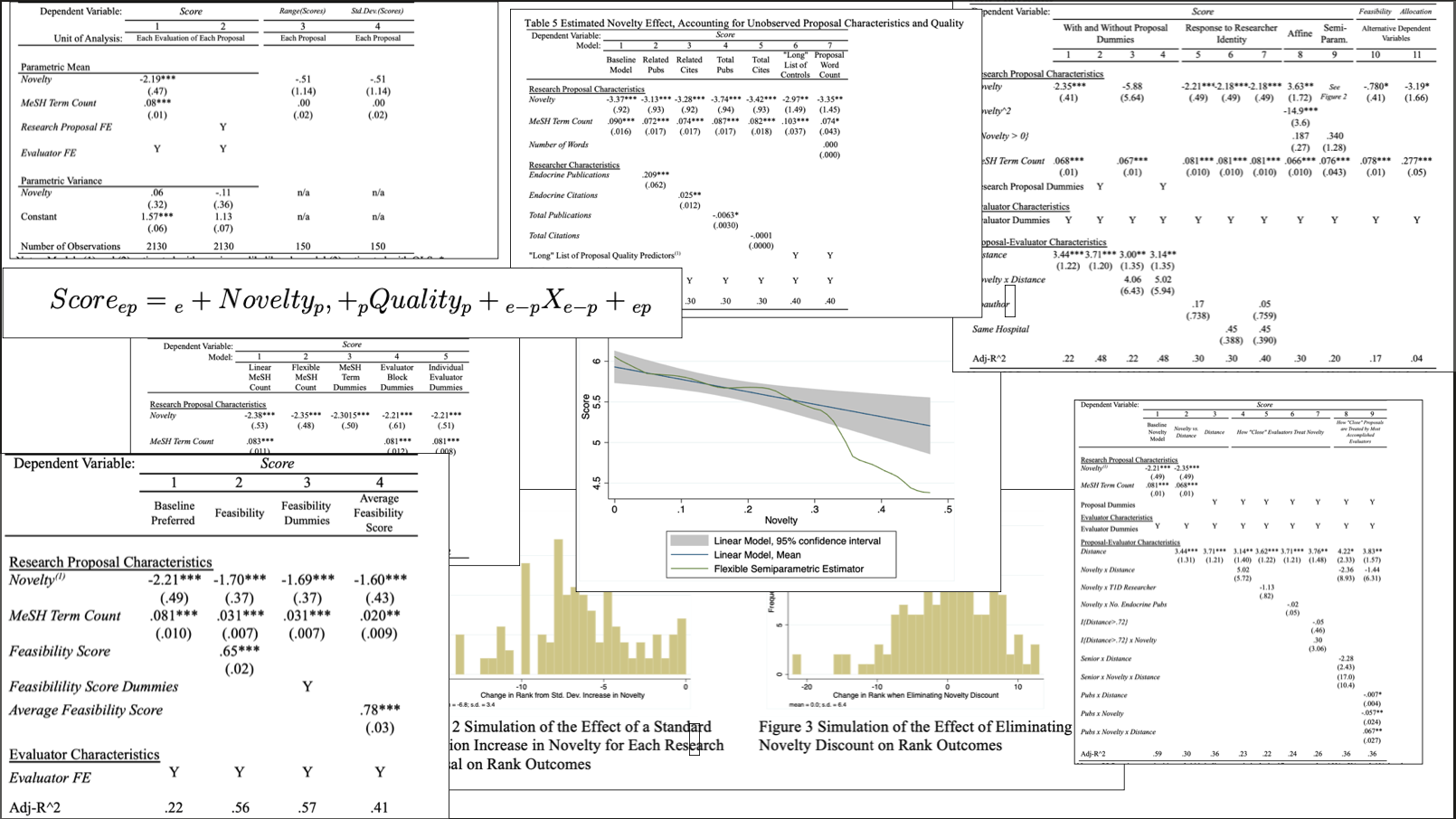

Они анализировали процесс оценки конкурса среди 150 заявок на медицинские гранты, которые оценивали 142 эксперта-преподавателя (от рядового до профессора) с подтвержденной компетентностью. Таким образом, в руки исследователей попали 2130 пар «заявка-оценка», которые прошли сложную процедуру анализа.

Что важно в контексте и дизайне исследования:

- «полевой эксперимент» был встроен в обычный процесс проведения грантового конкурса;

- распределение заявок было рандомизированным (т.е. назначение заявки эксперту происходило случайным образом);

- для чистоты использовался «тройной слепой» метод оценки (личности заявителей были сокрыты друг от друга, а личности оценщиков и факт их участия также сохранялись в тайне). Оценщики не взаимодействовали с друг другом. У них был доступ только к назначенным им заявкам;

- дизайн проблемы, на решение которой предлагался грант был определен с точки зрения «природы заболевания», а незнаний о нем. Это должно было стимулировать соискателей думать над более новыми идеями;

- из 150 заявителей почти половина (72) были из принимающего университета (т.е. который и проводил конкурс);

- эксперты были набраны из лучших преподавателей данного университета (это позволяло оценивать информацию об их личностях, связях, научных достижениях и карьере для проведения корреляции их оценочной работы);

- 142 эксперта были распределены в 3 группы, состав которых был сбалансирован по опыту, полу, возрасту и наличию научной степени и квалификации;

- все заявки были случайным образом распределены в 10 блоков, а каждому эксперту назначались по 15 случайно выбранных заявок, т.е. каждая заявка в среднем получала оценку от 14,2 эксперта :) ;

- оценка заявок экспертами осуществлялась по трем параметрам: «оценка влияния на лечение, пациентов или научное исследование», «оценка воспринимаемых достоинств предложения» и «оценка восприятия осуществимости предложения» (эта оценка особо важна для исследования).

Система анализа итогов строилась на трех параметрах: «Характеристики эксперта-оценщика», «Характеристики заявителя» и «Характеристики предложения на грант». Далее описана научно-исследовательская магия применения множества сложных формул, из которых получились не менее сложные графики и таблицы. Все очень интересно, но это мы опустим и перейдем к выводам.

А выводы неутешительные.

Команда исследователей обнаружила «большую, надежную, относительно стабильную и равномерную» практику «штрафование новизны».

Увеличение новизны в заявках приводило к падению рейтинга таких заявок в среднем на 4,5 процентиля (не процента!), что роняло заявку до 7 позиций в общем рейтинге.

Команда исследователей обнаружила «большую, надежную, относительно стабильную и равномерную» практику «штрафование новизны».

Увеличение новизны в заявках приводило к падению рейтинга таких заявок в среднем на 4,5 процентиля (не процента!), что роняло заявку до 7 позиций в общем рейтинге.

При этом:

- эксперты были более критичны к предложениям, которые были ближе к их области знаний;

- наиболее опытные и именитые эксперты пренебрегали новизной больше, чем остальная выборка экспертов. Но это пренебрежение было ниже, когда тема гранта касалась их области;

- «штрафы за новизну» были практически одинаковой величины у разных подвыборок экспертов, вне зависимости от их типов. Но разногласий по оценки «новизны» не возникало. Дисконтирование оценки было в целом равномерным;

- лишь примерно 25% в составе «штрафа» являлось субъективное мнение о низкой осуществимости инновационного предложения.

Авторы с сожалением констатируют, что такая цензура новизны в проектах означает, что «эти эксперименты никогда не будут поставлены» и резюмируют социальный эффект:

«это должно беспокоить политиков и общество в целом, поскольку драгоценные средства на исследования направляются на дополнение существующих исследований, а не в потенциально прорывные проекты. В естественных науках капиталоемкий характер большинства лабораторий означает, что отсутствие финансирования для первоначальной заявки на грант почти наверняка гарантирует, что ученые-заявители откажутся от этого направления исследования и направят свои усилия в более стандартные (нормальные) области науки».

Давайте посмотрим, почему это важно для нашей работы.

В практике российских грантовых программ чаще всего применяется «одинарная слепая оценка» (эксперты знают друг друга и видят, кто заявитель, но заявитель не знает, кто эксперты) и «двойная слепая оценка» (эксперты не знают друг друга, они видят заявителя, но заявитель не знает, кто эксперт). При этом, с учетом известной архитектуры экспертизы федеральных конкурсов ФПГ и ПФКИ, например, видно, что у них применяются оба вида – на этапе независимой экспертизы – «двойная слепая», а при работе экспертного совета – «одинарная слепая».

Мы не знаем наверняка, как именно набираются эксперты и какой у каждого контекст и уровень профессионализма (мы «слепы» в этом), но приведенное здесь исследование дает нам прочные основания полагать, что систематический штраф на новизну есть.

Более того, отсутствие анонимности заявителя перед экспертом имеет ряд последствий, также исследованных учеными, например:

- наличие каких-то сближающих связей между экспертом и заявителем приводит к более позитивным оценкам;

- характер самого проектного предложения оценивается по-разному (например, в исследованиях показано, что клинические испытания поддерживаются реже, чем лабораторные);

- наличие «стратегических рисков» для оценивающего эксперта, если грант слишком близок к его теме или зоне влияния, либо предлагаемое решение умаляет важность работы оценщика понижает оценку;

- эксперты из конкретной области могут быть склонны поддерживать релевантные заявки, просто чтобы поддержать развитие этой области;

- наличие эффекта «Вавилонской башни», когда представители одной «школы и культуры» проектной работы оценивают представителей другой «школы» и не могу полностью понять ценность и подходы проектных предложений в заявке, что понижает оценку (это отдельная проблема, о которой напишу в другом материале).

Все это важно учитывать, несмотря на то, что существует критерий оценки новизны. Как показало приведенное здесь исследование, декларативность инноваций и их реальная поддержка не полноценно коррелируют между собой.

При этом, совсем отказываться от «инновационности», конечно, не стоит, но делать это важно правильно, чтобы избежать получения «штрафа». Важно прибегать к стратегии «приемлемой новизны» своего проекта, которая бы удовлетворяла запрос на «инновационность», но не попадала бы в «штрафную зону».

О том, как строить «приемлемую новизну», а также о других важных стратегиях работы над заявками мы будем говорит на обучающей программе.

При этом, совсем отказываться от «инновационности», конечно, не стоит, но делать это важно правильно, чтобы избежать получения «штрафа». Важно прибегать к стратегии «приемлемой новизны» своего проекта, которая бы удовлетворяла запрос на «инновационность», но не попадала бы в «штрафную зону».

О том, как строить «приемлемую новизну», а также о других важных стратегиях работы над заявками мы будем говорит на обучающей программе.

👉 Предзапись на программу тут